Können Menschen und Maschinen einander verstehen? In einer explorativen Praxisstudie testeten wir mit 16 Testpersonen User Experience und Akzeptanz von Sprachassistenten bzw. Chatbots. Die Ergebnisse zeigen: Think big ist okay, start small ist der Weg zum Erfolg.

Intelligente Assistenten wie Alexa von Amazon und Google Home halten in immer mehr Haushalten Einzug und es gibt kaum eine Branche, in der nicht gerade mit Chatbots experimentiert wird.

Wir wollten wissen, ob solche Conversational Interfaces wirklich so einfach zu bedienen sind. Dazu haben wir innerhalb eines Jahres viele Chatbots und andere Conversational Interfaces ausprobiert, Menschen bei der Interaktion mit solchen Interfaces beobachtet und selbst Chatbots gebaut.

Wo liegen die Hürden?

In einer explorativen Praxisstudie wollten wir nun unsere Hypothesen aus einem Jahr Research überprüfen und präzisieren. Dazu testeten 16 Testpersonen für uns Conversational Interfaces.

Da wir wissen, dass die Konversation schon bei einfachen Chatbots oft schiefgeht, haben wir für unsere Praxisstudie bewusst weniger komplexe Chatbots ausgewählt; ein Registrierungsformular und eine Fahrplanabfrage. Wir wollten untersuchen,worin die kritischen Erfolgsfaktoren liegen. Das waren die wichtigsten Ergebnisse.

Top-Spracherkennung schürt Erwartungen

Die meisten Testpersonen konnten sich gut vorstellen, künftig Conversational Interfaces zu nutzen, gingen sogar davon aus, dass das von ganz alleine käme. Zwar wussten sie eingangs oft nicht, was und wie sie fragen sollen. Sobald sie merkten, wie gut die Spracherkennung funktioniert, hatten sie schnell den Eindruck, dass die Maschine sie versteht wie ein Mensch.

Da aber die Interpretation der Spracheingabe meist noch nicht so gut ist, ist das Frustrationspotential entsprechend hoch.

Die Akzeptanz hängt von der Alternative ab

Massstab der Kommunikation ist das persönliche Gespräch. Der Mensch versteht (fast) alles, kann Bilder zur Erklärung hervorziehen, die Voraussetzungen im Gespräch ändern, Fehlerkorrekturen verarbeiten. Müssen Chatbots zusätzlich mit der Informationseffizienz von guten, self-service-optimierten Apps konkurrieren, können sie im freien Dialog noch nicht mithalten.

Nützlichkeit braucht Kontext

Erst wenn die Nutzungssituation stimmt, zahlt sich die neue Interaktionsform aus.

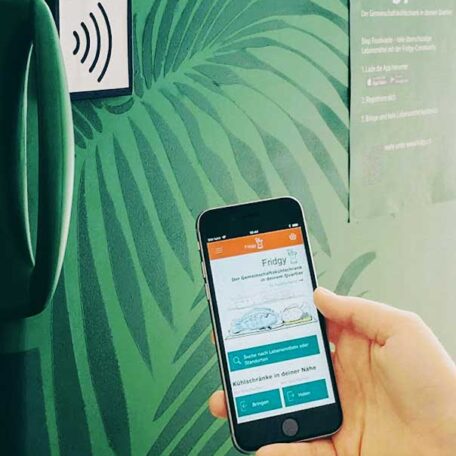

Interfaces mit Spracheingabe sind besonders nützlich in Kontexten, in denen man die Hände nicht frei hat.

Deshalb sollte das Öffnen des Interfaces möglichst interaktionsarm möglich sein, z.B. durch Zuruf.

Kontext heisst auch, dass die Fragen des Menschen aufeinander aufbauen können. Das hat bei unseren beiden Test-Bots gut funktioniert, ist jedoch bei vielen Bots ein Manko.

Erstmal anfreunden

Wenn ein Conversational Interface nur einen Anwendungsfall abbildet, wissen die User besser, wie und was sie fragen sollen. Der Erfolg der Interaktion ist berechenbar. Die «AnfängerInnen» in der Maschinenkommunikation konnten Sympathie aufbauen. Im Test wurde deutlich, dass die Testpersonen z.B. ein Formular als Chatbot hilfreich und angenehm empfinden, schon ganz ohne künstliche Intelligenz.

User-Experience-Tests sind ein Muss

Wie in den Anfängen des Web sind noch keine Standards für Interaktion und Content für Chatbots vorhanden. User Experience und Technologie sind noch viel enger verwoben als bei grafischen User Interfaces. Deshalb ist der Einbezug der Benutzer in den Entwicklungsprozess Pflicht.

Die Studienergebnisse im Detail

Geben Sie Ihre E-Mail-Adresse an, um den ausführlichen Report der Ergebnisse kostenlos per E-Mail zu erhalten.

Vielen Dank für Ihr Interesse. Wir haben Ihnen das Dokument soeben per E-Mail zugesendet.

Vielen Dank an Netcetera für die freundliche Unterstützung der Studie durch die Bereitstellung des Fahrplan-Chatbots, interessante Diskussionen und Unterstützung bei der Rekrutierung der Testpersonen.

Kommentare